La crescente presenza del generativo AI nelle operazioni governative

I governi statali e locali negli Stati Uniti stanno esplorando attivamente modi per implementare l’intelligenza artificiale generativa, come ChatGPT, per migliorare l’efficienza amministrativa e i servizi pubblici. Tuttavia, questa rapida adozione ha acceso dibattiti sulle implicazioni etiche, sulla sicurezza dei dati e sulla trasparenza pubblica. Sono evidenti le incoerenze nell’approccio normativo nei confronti di queste tecnologie avanzate. Ad esempio, la US Environmental Protection Agency ha vietato l’accesso dei dipendenti a ChatGPT, mentre il personale del Dipartimento di Stato americano in Guinea lo utilizza per vari compiti come la stesura di discorsi.

Il miscuglio: approcci diversi nei vari Stati

Vari stati mostrano atteggiamenti contrastanti nei confronti dell’IA generativa. Il Maine, ad esempio, ha imposto un divieto temporaneo all’uso dell’intelligenza artificiale generativa da parte del suo ramo esecutivo, citando preoccupazioni sulla sicurezza informatica. In netto contrasto, il Vermont sta incoraggiando i suoi dipendenti governativi a utilizzare la tecnologia per scopi educativi, come l’apprendimento di nuovi linguaggi di programmazione, come rivelato da Josiah Raiche, direttore statale dell’intelligenza artificiale.

Governi locali e intelligenza artificiale generativa: uno sguardo più da vicino

I Comuni stanno inoltre formulando linee guida per regolamentare l’uso dell’IA generativa. San Jose, in California, ha redatto un documento di linee guida completo di 23 pagine e richiede ai dipendenti comunali di compilare moduli ogni volta che utilizzano strumenti di intelligenza artificiale come ChatGPT. La contea di Alameda, non lontana da San Jose, opta per un approccio più flessibile. Sebbene abbiano organizzato sessioni educative sui rischi associati all’intelligenza artificiale, non hanno ancora stabilito una politica formale. Sybil Gurney, assistente responsabile delle informazioni della contea, ha osservato che il loro focus è su “ciò che puoi fare, non su ciò che non puoi fare”.

Ottimismo temperato dalla responsabilità

I funzionari governativi riconoscono il potenziale dell’intelligenza artificiale generativa per alleviare le inefficienze burocratiche. Tuttavia, sottolineano anche le sfide uniche poste dal bisogno di trasparenza del settore pubblico, dal rispetto di leggi severe e dal senso generale di responsabilità civica. Jim Loter, responsabile tecnologico ad interim di Seattle, sottolinea l'elevato livello di responsabilità richiesto quando si implementa l'intelligenza artificiale nei processi governativi. Ritiene che la divulgazione pubblica e pratiche eque debbano essere una priorità, soprattutto data l’elevata posta in gioco nel processo decisionale del governo.

Scenari che evidenziano la posta in gioco: un caso in Iowa

Gli eventi recenti hanno dimostrato quanto alta possa essere la posta in gioco. Il mese scorso, un assistente sovrintendente di Mason City, Iowa, ha utilizzato ChatGPT per decidere quali libri dovrebbero essere rimossi dalle biblioteche scolastiche. Questo incidente, imposto dalla legge statale, ha attirato l’attenzione e il controllo nazionale, sollevando interrogativi sulla responsabilità delle decisioni sull’intelligenza artificiale nel governo.

Leggi sui registri pubblici e sicurezza dei dati

Esiste un ulteriore livello di complessità: i registri pubblici e la sicurezza dei dati. San Jose, Seattle e lo Stato di Washington hanno avvisato il personale che tutti i dati utilizzati nei modelli di intelligenza artificiale generativa sono soggetti alle leggi sui registri pubblici. Queste informazioni vengono utilizzate anche per addestrare questi modelli di intelligenza artificiale, aumentando il rischio che informazioni sensibili vengano divulgate o gestite in modo improprio. Inoltre, uno studio dello Stanford Institute for Human-Centered Artificial Intelligence sottolinea che quanto più accurati diventano questi modelli di intelligenza artificiale, tanto più è probabile che riutilizzino grandi blocchi di contenuti dai loro set di addestramento.

Sfide in sanità e giustizia penale

Le agenzie sanitarie e di giustizia penale si trovano ad affrontare un’ulteriore serie di problemi. Considera la situazione ipotetica in cui i dipendenti di Seattle utilizzano l’intelligenza artificiale per riassumere i rapporti investigativi del loro Office of Police Accountability. Questi rapporti possono contenere informazioni sensibili ma che rientrano comunque nei registri pubblici, aggiungendo un livello di complessità al loro utilizzo responsabile.

Implicazioni legali e fiducia pubblica

In Arizona, i dipendenti della Corte superiore della contea di Maricopa utilizzano l’intelligenza artificiale generativa per scopi interni, ma Aaron Judy, responsabile dell’innovazione e dell’intelligenza artificiale della corte, ammette che ci sarebbero riserve sull’utilizzo per le comunicazioni pubbliche. La preoccupazione di fondo è il dilemma etico legato all’utilizzo del contributo dei cittadini per addestrare un modello di intelligenza artificiale orientato al profitto.

L’intelligenza artificiale generativa nella tecnologia civica e nelle politiche future

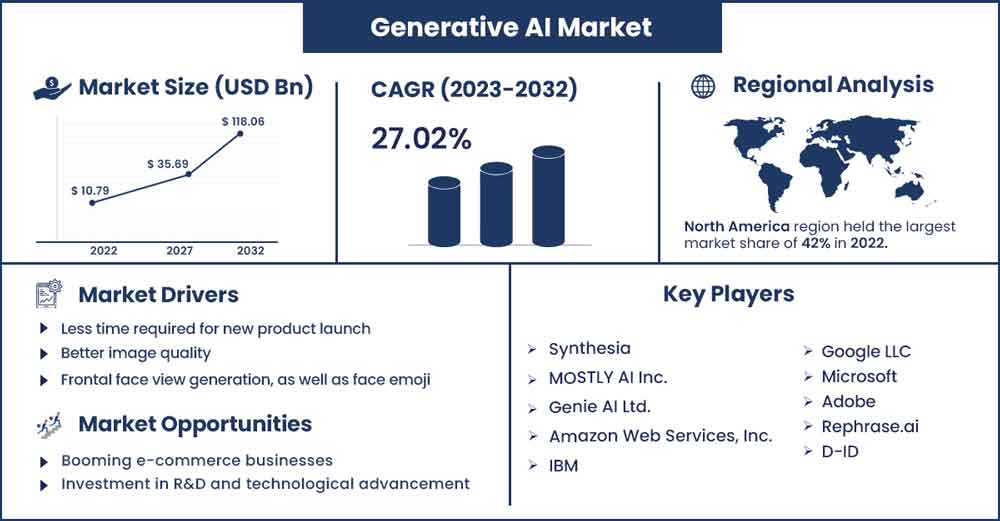

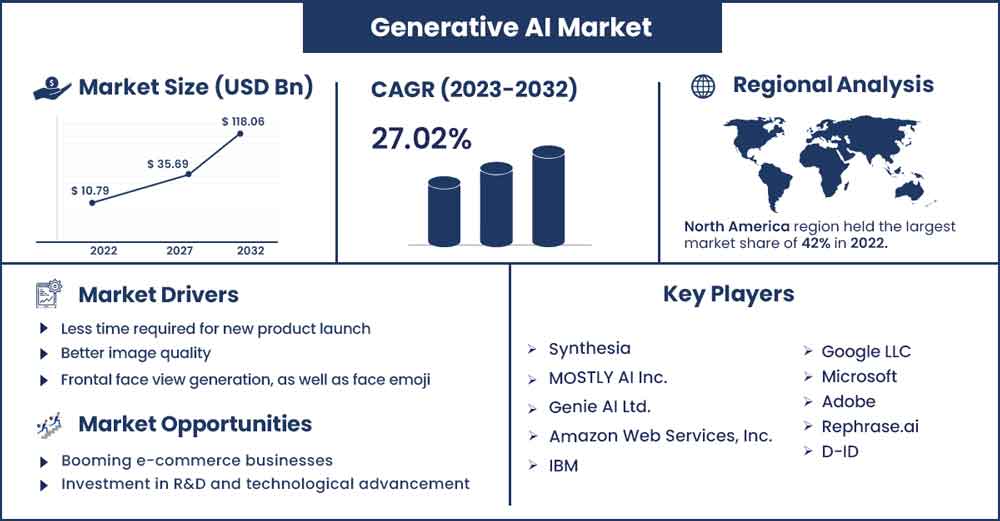

Le principali società tecnologiche e società di consulenza, come Microsoft, Google, Deloitte e Accenture, stanno promuovendo attivamente soluzioni di intelligenza artificiale generativa a livello federale. Si prevede che le città e gli stati affineranno e miglioreranno le loro politiche nei prossimi mesi. Albert Gehami, responsabile della privacy di San Jose, prevede che queste regole subiranno un'evoluzione sostanziale man mano che la tecnologia maturerà.

La necessità di una supervisione federale

Sebbene i governi locali e statali abbiano fatto i primi passi avanti nella formulazione delle politiche sull’intelligenza artificiale, c’è un urgente bisogno di linee guida federali. Alexandra Reeve Givens, presidente e amministratore delegato del Center for Democracy and Technology, ritiene che la situazione richieda una “chiara leadership” da parte del governo federale per stabilire protocolli dettagliati e standardizzati.

Conclusione: il Balancing Act

Man mano che le tecnologie di IA generativa diventano sempre più integrate nelle operazioni governative, la sfida sarà quella di trovare un equilibrio tra lo sfruttamento delle loro capacità a beneficio pubblico e la garanzia della sicurezza dei dati, degli standard etici e della trasparenza. Mentre i governi continuano a sperimentare e apprendere, un attento esame e un’implementazione responsabile saranno le chiavi per sfruttare tutto il potenziale di questa tecnologia trasformativa.